Synthetisierung von Multi-Instanz-Human-Matting-Daten mit MaskRCNN und BG20K

Inhaltsverzeichnis der Links

Abstrakt und 1. Einleitung

-

Verwandte Arbeiten

-

MaGGIe

3.1. Effizientes maskiertes geführtes Instanz-Matting

3.2. Feature-Matte temporale Konsistenz

-

Instanz-Matting-Datensätze

4.1. Bild-Instanz-Matting und 4.2. Video-Instanz-Matting

-

Experimente

5.1. Vortraining auf Bilddaten

5.2. Training auf Videodaten

-

Diskussion und Referenzen

\ Ergänzungsmaterial

-

Architekturdetails

-

Bild-Matting

8.1. Datensatzgenerierung und -vorbereitung

8.2. Trainingsdetails

8.3. Quantitative Details

8.4. Weitere qualitative Ergebnisse zu natürlichen Bildern

-

Video-Matting

9.1. Datensatzgenerierung

9.2. Trainingsdetails

9.3. Quantitative Details

9.4. Weitere qualitative Ergebnisse

8. Bild-Matting

Dieser Abschnitt erweitert den Bild-Matting-Prozess und bietet zusätzliche Einblicke in die Datensatzgenerierung sowie umfassende Vergleiche mit bestehenden Methoden. Wir vertiefen uns in die Erstellung der Datensätze I-HIM50K und M-HIM2K, bieten detaillierte quantitative Analysen und präsentieren weitere qualitative Ergebnisse, um die Wirksamkeit unseres Ansatzes zu unterstreichen.

8.1. Datensatzgenerierung und -vorbereitung

Der I-HIM50K-Datensatz wurde aus dem HHM50K [50]-Datensatz synthetisiert, der für seine umfangreiche Sammlung menschlicher Bild-Mattes bekannt ist. Wir verwendeten ein MaskRCNN [14] Resnet-50 FPN 3x-Modell, trainiert auf dem COCO-Datensatz, um Einzelpersonenbilder herauszufiltern, was zu einer Teilmenge von 35.053 Bildern führte. Nach der InstMatt [49]-Methodik wurden diese Bilder gegen verschiedene Hintergründe aus dem BG20K [29]-Datensatz komponiert, wodurch Multi-Instanz-Szenarien mit 2-5 Subjekten pro Bild erstellt wurden. Die Subjekte wurden in der Größe angepasst und positioniert, um eine realistische Skalierung beizubehalten und übermäßige Überlappungen zu vermeiden, wie durch Instanz-IoUs von nicht mehr als 30% angegeben. Dieser Prozess ergab 49.737 Bilder mit durchschnittlich 2,28 Instanzen pro Bild. Während des Trainings wurden Führungsmasken durch Binarisierung der Alpha-Mattes und Anwendung zufälliger Dropout-, Dilatations- und Erosionsoperationen generiert. Beispielbilder aus I-HIM50K sind in Abb. 10 dargestellt.

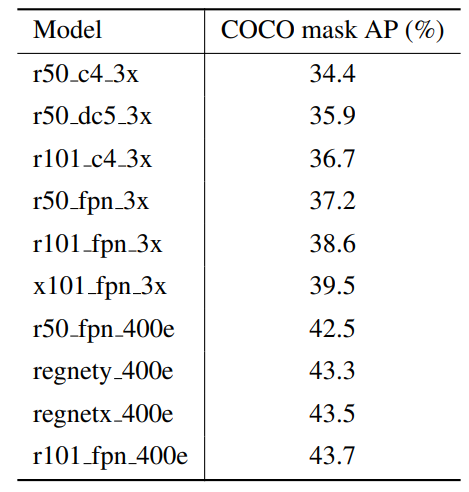

\ Der M-HIM2K-Datensatz wurde entwickelt, um die Modellrobustheit gegenüber variierenden Maskenqualitäten zu testen. Er umfasst zehn Masken pro Instanz, die mit verschiedenen MaskRCNN-Modellen generiert wurden. Weitere Informationen zu den für diesen Generierungsprozess verwendeten Modellen sind in Tabelle 8 dargestellt. Die Masken wurden basierend auf dem höchsten IoU mit den Ground-Truth-Alpha-Mattes den Instanzen zugeordnet, wobei ein minimaler IoU-Schwellenwert von 70% sichergestellt wurde. Masken, die diesen Schwellenwert nicht erfüllten, wurden künstlich aus Ground Truth generiert. Dieser Prozess führte zu einem umfassenden Satz von 134.240 Masken, davon 117.660 für zusammengesetzte und 16.600 für natürliche Bilder, was einen robusten Benchmark zur Bewertung des maskierten geführten Instanz-Mattings bietet. Der vollständige Datensatz I-HIM50K und M-HIM2K wird nach Annahme dieser Arbeit veröffentlicht.

\

\

\

:::info Autoren:

(1) Chuong Huynh, University of Maryland, College Park (chuonghm@cs.umd.edu);

(2) Seoung Wug Oh, Adobe Research (seoh,jolee@adobe.com);

(3) Abhinav Shrivastava, University of Maryland, College Park (abhinav@cs.umd.edu);

(4) Joon-Young Lee, Adobe Research (jolee@adobe.com).

:::

:::info Dieses Paper ist auf arxiv verfügbar unter CC by 4.0 Deed (Attribution 4.0 International) Lizenz.

:::

\

Das könnte Ihnen auch gefallen

Bitcoin behält Vorsprung bei Marktschwankungen

Eumir Marcial sichert sich die einzige Boxgoldmedaille der Philippinen bei den SEA Games 2025